Guida autonoma e IA: il MIT alla ricerca dei punti deboli

Gli studiosi del MIT di Boston alla ricerca delle debolezze dell'Intelligenza Artificiale alla base della guida autonoma

Guida autonoma: un conto è avere fiducia nel progresso ed essere favorevoli all'avvento della guida robotizzata sulla base di test effettuati in laboratorio o su strade chiuse al pubblico, un altro è fidarsi effettivamente della capacità di una vettura guidata dall'Intelligenza Artificiale nel mondo reale (a proposito, date un'occhiata se non l'avete già fatto al nostro SPECIALE). Per questo i ricercatori del MIT di Boston hanno cercato di individuare le differenze tra la teoria e la pratica.

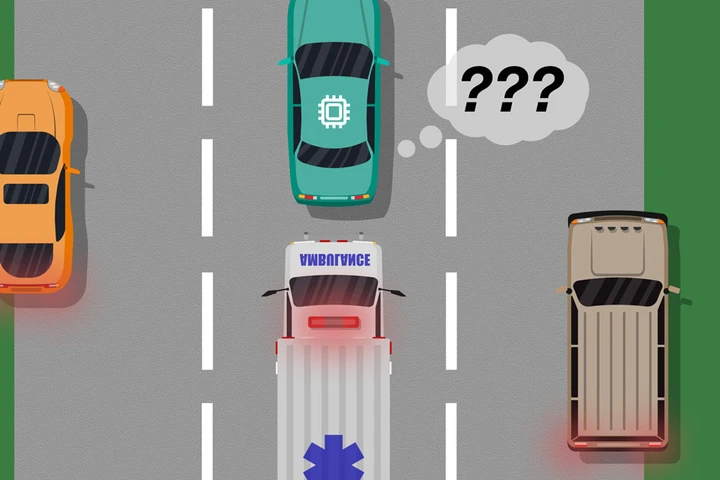

Il risultato (link in FONTE) è un modello di situazioni in cui cui le nozioni teoriche non corrispondono agli eventi, spesso imprevedibili, che possono accadere nella vita reale. Per esempio: se un'auto autonoma non è stata "addestrata" o non ha i sensori per riconoscere la differenza tra un furgone bianco e un'ambulanza, l'auto in questione potrebbe non adottare il comportamento tipico di queste situazioni, ovvero accostare e lasciare passare l'ambulanza.

Sono numerosi i punti deboli (definiti "blind spot") dell'Intelligenza Artificiale emersi durante le simulazioni. Per identificarli, i ricercatori hanno "affiancato" l'Intelligenza Artificiale, intervenendo con dei feedback per correggerne gli errori. In questo modo, si forniscono all'IA informazioni più complete su una determinata situazione, consentendole di effettuare scelte più corrette e sicure in futuro.

Questo sistema funzionerà anche in tempo reale, purché dietro al volante ci sia un essere umano: qualora questa persona – dopo aver rilevato un errore del sistema di guida autonoma – dovesse prendere il controllo del volante, l'AI imparerebbe da questa situazione adattando di conseguenza il proprio comportamento nel caso in cui si ripresentasse una situazione simile in futuro. Così Ramya Ramakrishnan, uno dei ricercatori del laboratorio di Informatica e Intelligenza Artificiale del MIT nonché autore dello studio, ha spiegato il modello di simulazione:

Il modello aiuta i sistemi autonomi a conoscere meglio ciò che non conoscono. Molte volte, quando questi sistemi vengono implementati, le loro simulazioni addestrate non corrispondono al contesto reale e potrebbero commettere errori. L'idea è di sfruttare gli umani per colmare il divario tra la simulazione e il mondo reale, in modo sicuro, in modo da poter ridurre alcuni di questi errori.