Moral Machine: il questionario morale sulla guida autonoma

I ricercatori del digital media lab del MIT di Boston hanno creato una piattaforma in grado di raccogliere dei dati dal punto di vista umano su una delle questioni etiche più discusse del momento: cosa spingerà le auto autonome a prendere una decisione

I ricercatori del digital media lab del MIT di Boston hanno creato una piattaforma in grado di raccogliere dei dati dal punto di vista umano su una delle questioni etiche più discusse del momento: cosa spingerà le auto autonome a prendere una decisione piuttosto che un’altra?

Si chiama Moral Machine la piattaforma sviluppata da alcuni professori, ricercatori e studenti del digital media lab del MIT di Boston, una delle università più all’avanguardia nella ricerca e nello sviluppo della guida autonoma.

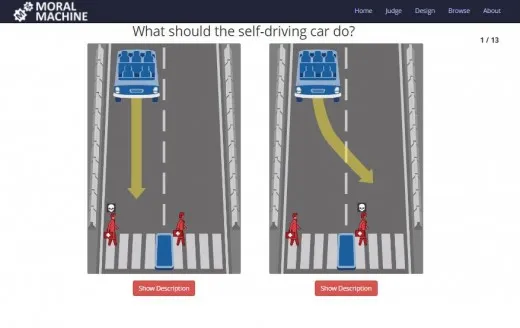

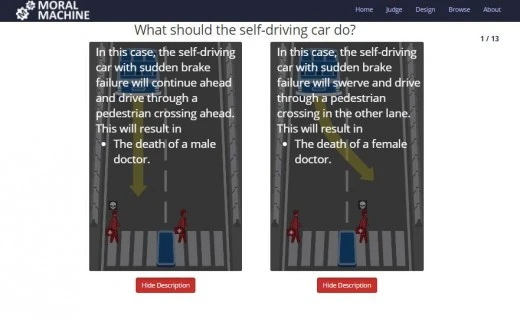

Tramite un questionario molto semplice ed intuitivo Moral Machine sottopone agli intervistati (qui il link) una serie di “dilemmi" di carattere etico e morale, dove una vettura a guida autonoma deve optare per il male minore, tra cui, per esempio, uccidere i due passeggeri cinque pedoni. Le persone che svolgono il questionario devono decidere quale sarebbe la migliore decisione che la macchina dovrebbe prendere, decidendo dunque in maniera indiretta chi salvare e chi “sacrificare" come “male minore".

Tutte le situazioni proposte partono con il presupposto che la vettura a guida autonoma abbia un guasto ai freni per il quale sarà impossibile fermarsi in tempo. Le alternative proposte dal sistema saranno quindi due: per esempio, è possibile decidere se la vettura investirà due pedoni che stanno attraversando sulle strisce (salvando il passeggero della vettura) oppure opterà per salvare i pedoni, facendo schiantare la vettura contro un muro.

Tra le varie combinazioni ci sono poi delle varianti da non sottovalutare: è giusto sacrificare il passeggero della vettura anche se i pedoni stanno attraversando con il rosso? O è meglio investirli perché stavano trasgredendo la legge e quindi “se la sono cercata". Oppure ancora, se dovesse attraversare un cane innocente sarebbe il caso di salvare lui o il passeggero della vettura?

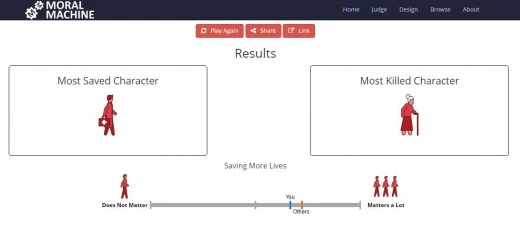

Tutte queste domande di carattere etico e morale vengono poi utilizzate per resituire all’intervistato un report in cui potrà confrontare le proprie scelte con quelle della media degli altri intervistati, stimolando una discussione nella community. Inoltre è possibile creare degli inediti scenari da sottoporre agli altri intervistati.

La piattaforma non è uno strumento per giudicare la coscienza delle persone (come potrebbe sembrare ad uno sguardo poco attendo al report) ma, anzi, un mezzo per cercare di capire quali sono i potenziali scenari e le conseguenze morali di azioni che non potranno essere prese da esseri umani ma da robot intelligenti.